Как развернуть DeepSeek на своем сервере

В этой статье расскажем, как развернуть модель DeepSeek на собственном сервере для использования ИИ в закрытой и управляемой среде.

Локальный запуск DeepSeek на собственных ресурсах повышает скорость работы нейросети, конфиденциальность данных и позволяет гибко настраивать ее под задачи пользователя. Благодаря этой статье вы сможете развернуть DeepSeek, а также ограничить доступ к ней для нескольких устройств в локальной сети.

Какую модель будем использовать?

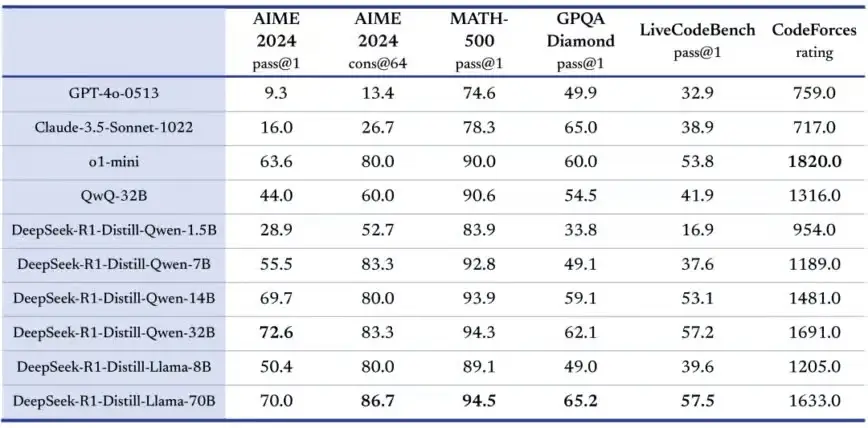

DeepSeek-R1 — это мощная модель с 671 миллиардом параметров и архитектурой Mixture of Experts. Для запуска потребуется около 1,5 ТБ видеопамяти — это слишком большие требования для большинства домашних устройств. Вместо неё можно использовать облегченную версию DeepSeek-R1-Distill-Qwen-7B. Эта модель гораздо легче, но при этом сохраняет высокую точность, так как была обучена на данных, сгенерированных оригинальной DeepSeek-R1.

Зачем запускать DeepSeek на своём сервере?

Под «собственным» сервером в этой статье мы понимаем арендуемую машину с GPU в облаке.. Это не физический домашний ПК, а изолированная, управляемая среда с выделенными ресурсами, где только вы контролируете, что и как работает. Такой подход позволяет развернуть DeepSeek в защищенной среде, без рисков, связанных с передачей данных в сторонние сервисы.

Преимущества размещения DeepSeek на облачном сервере:

- Конфиденциальность. Данные остаются в пределах вашей инфраструктуры, никуда не выгружаются и не обрабатываются вне вашей зоны контроля.

- Высокая скорость. Облачные серверы с GPU (например, NVIDIA L40S) обеспечивают максимальную эффективность при обучении и инференсе нейросетей

- Настройка под задачи. Можно выбрать нужную конфигурацию: объем видеопамяти, тип CPU, количество памяти, тип диска и поменять ее при необходимости.

- Отсутствие вложений в железо. Не нужно покупать дорогостоящую рабочую станцию, настраивать ее и поддерживать. Инфраструктура уже готова к запуску.

- Разворачивая модель самостоятельно, вы глубже разбираетесь в устройстве нейросетей и их работе.

Стоит ли разворачивать модель на физическом сервере?

Такой вариант возможен, если у вас уже есть подходящее железо. Но чаще всего он сопровождается рядом минусов:

- Значительные затраты на покупку видеокарт с большим объёмом памяти (L40S, L4, A100 и пр.).

- Необходимость подбирать и находить оборудование, а также его сборка.

- Высокая потребляемая мощность сервера

- Необходимость постоянной технической поддержки оборудования и его обновление.

Поэтому для большинства задач проще и выгоднее выбрать облачную инфраструктуру. Она масштабируется под вашу нагрузку, не требует поддержки инфраструктуры с вашей стороны и доступна для работы в кратчайшие сроки.

Что потребуется для запуска DeepSeek

Чтобы модель работала стабильно и быстро, понадобится сервер с определёнными параметрами. Мы рекомендуем следующую базовую конфигурацию для запуска DeepSeek-R1:7B:

- Процессор: от 12 ядер (например, AMD EPYC 9374F или Intel Xeon Gold 6354)

- Видеокарта: NVIDIA с поддержкой CUDA (например, NVIDIA L4 или NVIDIA L40S). Также возможна работа на AMD, но это менее популярный вариант.

- Оперативная память: от 16 ГБ, для больших моделей — от 32 ГБ.

- Дисковая подсистема: NVMe-накопители с высокой скоростью обмена данными и низкой задержкой.

- ОС: для полной совместимости рекомендуются Ubuntu или дистрибутивы на основе Ubuntu.

Сервер с подобными характеристиками можно взять в аренду в mClouds. Это позволит избежать затрат на покупку железа, быстро масштабироваться и получить высокую производительность DeepSeek

Установка DeepSeek

Поскольку процесс запуска модели DeepSeek будет происходить на облачном сервере, то для начала необходимо арендовать его через личный кабинет mClouds. В статье будем использовать тарифный план X4-8GB: NVIDIA L4 8 Гб, CPU Intel Xeon Gold 6354 3.9 Ггц, RAM - 16 Гб, SSD - 90 Гб. Такой сервер полностью подходит для запуска моделей DeepSeek.

Отдельно стоит отметить, что после заказа специалисты техподдержки подготовят сервер для работы с нейросетями и установят необходимые драйверы. Вам останется только подключиться к серверу и приступить к работе.

Устанавливать DeepSeek будем через Ollama — это инструмент, предназначенный для локального запуска моделей ИИ. Откройте терминал и запустите:

curl -fsSL https://ollama.com/install.sh | sh

Эта команда загружает и выполняет скрипт установки Ollama. Во время установки Ollama автоматически настроится и запустит необходимые службы. После завершения процесса проверьте установку:

ollama --version

Чтобы проверить, запущена ли Ollama, используйте:

systemctl is-active ollama.service

Если вывод равен active, то служба запущена, и можно перейти к следующему шагу.

Если нет, запустите ее вручную:

sudo systemctl start ollama.service

Чтобы всегда запускать службу при загрузке системы, выполните:

sudo systemctl enable ollama.service

Чтобы загрузить и запустить 7b модель, используйте команду:

ollama run deepseek-r1:7b

Подключение через веб-интерфейс Open WebUI

Для удобной работы с DeepSeek установите Open WebUI — централизованную панель управления.

Способ 1. Через установщик пакетов Python pip:

pip3 install open-webui

Способ 2. Через Snap:

sudo apt update sudo apt install snapd sudo snap install open-webui --beta

Запуск Open WebUI:

После установки запустите Open WebUI с помощью команды:

open-webui serve

Если предыдущие шаги выполнены верно, то ваш сервер будет доступен по адресу http://localhost:8080, где «localhost» это локальный IP-адрес вашего сервера. Для доступа к серверу с других устройств понадобится сделать ряд действий, которые мы описали в продолжении статьи.

Использование обратного прокси на базе Nginx

Если вы хотите обращаться к серверу по доменному имени с использованием SSL сертификатов, то вы можете настроить Nginx в качестве обратного proxy. Зарегистрировать доменное имя вы можете, воспользовавшись нашей статьей. Сгенерировать свои SSL сертификаты вы можете при помощи сервиса Let’s Encrypt.

1. Установите Nginx:

sudo apt install nginx

2. Создайте конфигурацию обратного прокси-сервера:

sudo vi /etc/nginx/sites-available/deepseek

3. Добавьте следующую конфигурацию:

server {

listen 80;

server_name your-local-domain.local;

location / {

proxy_pass http://localhost:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}4. Включите и перезапустите Nginx:

sudo ln -s /etc/nginx/sites-available/deepseek /etc/nginx/sites-enabled/ sudo nginx -t # Test the configuration sudo systemctl restart nginx

Теперь доступ к интерфейсу будет осуществляться по адресу:

http://your-local-domain.local

Заключение

Таблица бенчмарков: 6 моделей, взятых из DeepSeek-R1 и имеющих полностью открытый исходный код.

Запуск DeepSeek на собственных ресурсах предоставляет больше контроля над нейросетью, повышает ее конфиденциальность и производительность. Такой подход будет полезен разработчикам и ИТ-специалистам, которым важна производительность, автономность и возможность гибкой настройки ИИ.

Максимальной скорости и производительности DeepSeek можно добиться, арендовав облачные серверы с GPU NVIDIA L4 или NVIDIA L40S. Последний вариант это топовое решение для задач с ИИ, обучением и инференсом нейросетей высокой интенсивности. Серверы с GPU доступны для тестирования.

Выбираем видеокарту для ИИ до 24GB: обзор и сравнение NVIDIA L4 и T4

Выбираем видеокарту для ИИ до 24GB: обзор и сравнение NVIDIA L4 и T4Сравниваем видеокарты для работы с нейросетями NVIDIA T4 16GB и её обновление в виде NVIDIA L4 24Gb. Детально про технические характеристики, проверим реальную производительность в задачах машинного обучения и разберемся, какая из них лучше справляется с инференсом больших языковых моделей и другими ML-задачами. Это поможет понять, стоит ли в 2026 году выбирать устаревшую T4 или лучше присмотреться к L4.

03 декабря, 2025 Ноябрьский дайджест: тестируем S3 и развиваем GPU-платформу

Ноябрьский дайджест: тестируем S3 и развиваем GPU-платформуВ ноябре тестируем наше S3 хранилище, открыли предзаказ на новейшие GPU NVIDIA RTX Pro 6000 Blackwell Server Edition 96GB и cнизили стоимость аренды сервера с видеокартой NVIDIA L4 24GB. А также написали новые статьи и сделали ряд апдейтов облачной платформы в ноябре.

02 декабря, 2025 Как использовать GPU сервер на максимум для работы с нейросетями

Как использовать GPU сервер на максимум для работы с нейросетямиВ статье рассказываем, как устранить бутылочное горлышко в работе серверов с GPU и заставить работать видеокарту для ИИ более чем на 90%.

13 ноября, 2025